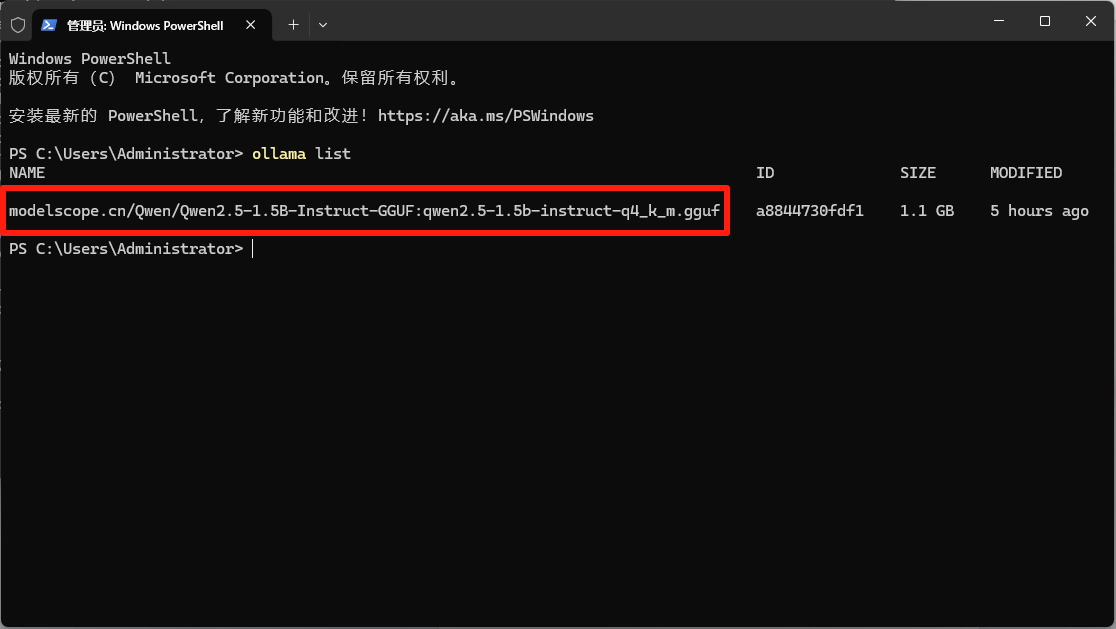

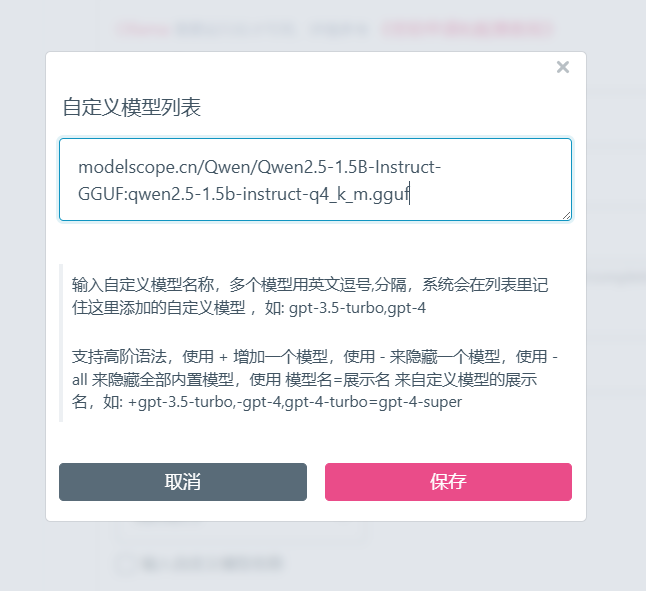

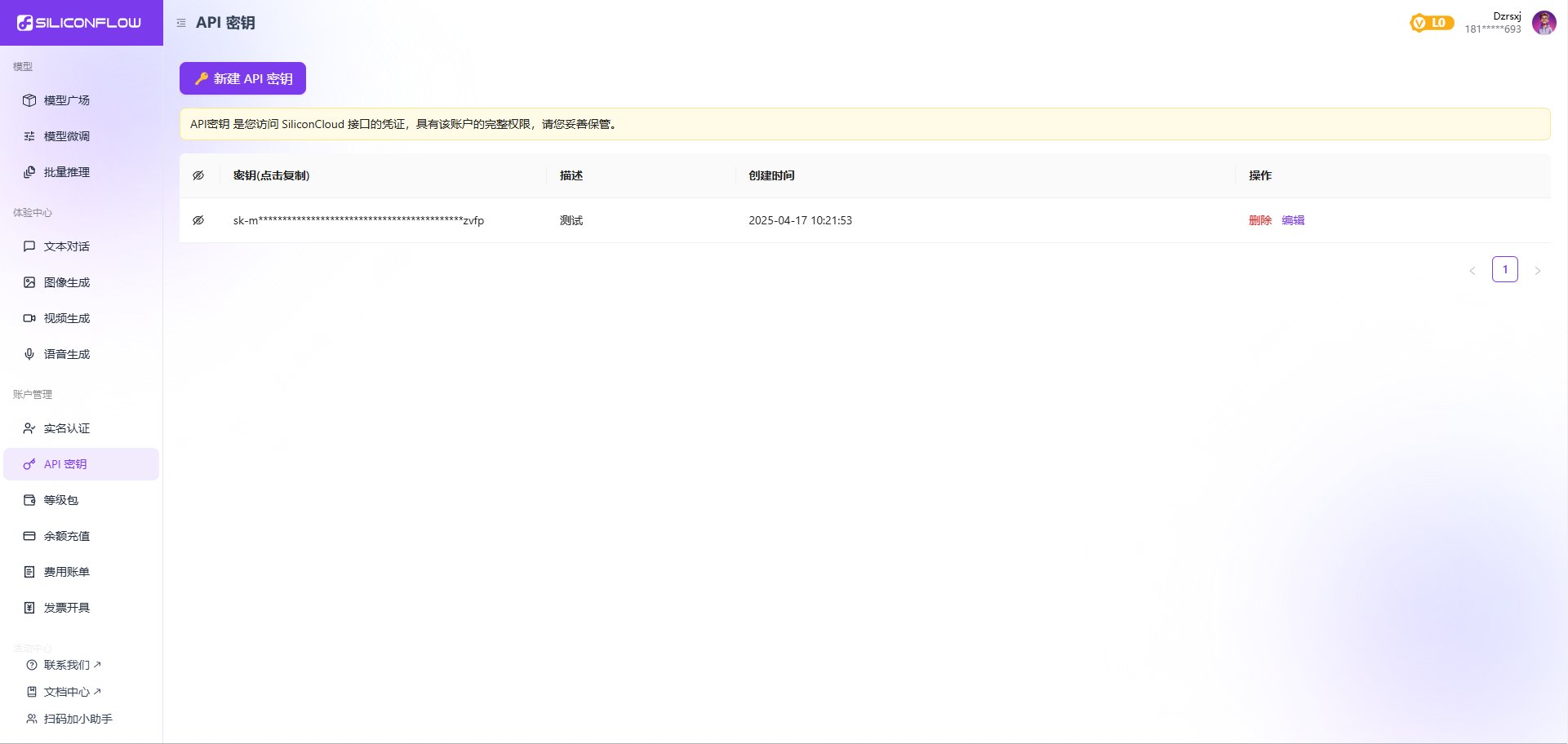

沉浸式翻译 Chrome插件 对接本地 Ollama 大模型 笔记 home 编辑时间 2025/04/17 <br><br> ## 前言 <br><br> ## 折腾 <br> **首先肯定是必须已经正确安装ollama** 并且已经至少有一个模型 没有的话可以看我上一篇笔记 https://leanote.zzzmh.cn/blog/post/67ff6489c0a657000b0b3180 <br> **用powershell检查现有模型** ```shell ollama list # 我这里返回 PS C:\Users\Administrator> ollama list NAME ID SIZE MODIFIED modelscope.cn/Qwen/Qwen2.5-1.5B-Instruct-GGUF:qwen2.5-1.5b-instruct-q4_k_m.gguf a8844730fdf1 1.1 GB 5 hours ago ``` <br> **安装沉浸式翻译** 下载地址 https://chrome.zzzmh.cn/info/bpoadfkcbjbfhfodiogcnhhhpibjhbnh 安装教程 https://chrome.zzzmh.cn/article/uwucpk21bgok1tk6ygo8w4d9bfubn6pv <br> **设置对接本地大模型** 进入 `设置` 随手可以把收费的用不到的一些全部关闭掉 找到ollama(新版沉浸式翻译才有这个选项) 打开开关,点击去修改  <br> 这时候如果直接点 `点此测试服务` 就会出现一段404的报错信息 原因是模型选择,必须是你本地name下存在的模型名称  <br> 点击模型选择下拉框,到最后,选择设置更多模型 然后把powershell中`ollama list`返回值中的name填入 (powershell中 长安拖动选择文本,对着选中文本右击,就直接复制成功)  <br> name填入自定义模型列表  <br> 那我这里的模型名称只能填写 `modelscope.cn/Qwen/Qwen2.5-1.5B-Instruct-GGUF:qwen2.5-1.5b-instruct-q4_k_m.gguf`  <br> 下拉框再选择一次就可以了  <br> 最后在右上角点 `点击测试服务` 显示绿色验证成功,说明设置好了 其余可以默认  <br> 翻译效果肯定是deepseek v3更强 但是这里也要考量速度问题 所以qwen2.5 7b/14b 或者deepseek r1 7b/14b 更适合做这个工作 毕竟首先要翻译的快,然后才考虑准不准的问题 qwen2.5 1.5b亲测不行,完全是夏姬八翻译 <br> 在github上随便找个英语界面 简单双语翻译一下,除了qwen1.5b水平一般 其余完全没毛病 正在下载qwen32b和deepseekr1 32bq4 如果这2个翻译速度OK的话,翻译效果是可以媲美线上接口的  <br><br> 此外我还发现,这里面居然还有硅基流动 那么就可以白嫖硅基流动的免费token了 爽歪歪 <br> 注册 [硅基流动](https://cloud.siliconflow.cn/i/2u9olIBn) 并点击首页 API密钥 获取API密钥 https://cloud.siliconflow.cn/account/ak  注册用户免费包含一个qwen2.5 7b 首次使用还免费送14元余额可以用来调收费的token 这里只演示如何免费白嫖 <br> 点击api密钥复制 粘贴到沉浸式翻译 设置界面的 硅基流动中 然后点击 `点此测试服务`  <br> 测试后效果还可以,至少比谷歌翻译、微软翻译 强了很多 也比不填API的硅基流动的响应要快很多  <br><br> ## END 送人玫瑰,手留余香 赞赏 Wechat Pay Alipay Ubuntu 24.04 LTS 本地部署 ComfyUI + Flux + Nunchaku 完整安装指南 Windows11 Ollama Deepseek 通义千问 CherryStudio MCP入门笔记